"המחשב אומר שהתמונה מזויפת!": האיום החדש על ההסברה הישראלית

כלי חינמי לזיהוי תמונות שיוצרו באמצעות בינה מלאכותית זיהה כמזויפת תמונה המתעדת פעוט ישראלי שנרצח בידי חמאס • גולשים מיהרו להאשים את ישראל בשקרים - אף שאמיתות התמונה אושרה בידי עיתונאים זרים • בטוויטר תיקנו לבסוף את הטעות אך הנזק כבר נגרם • הסיפור ממחיש עד כמה היכולת לייצר תמונות מפוברקות מסבכת את המערכה על האמת ברשת

המלחמה של ישראל בזירת ההסברה נתקלת בבעיה חדשה שכמותה לא הכירה: האשמות שגויות בשימוש בעיבודי מחשב כדי לזייף תמונות המתעדות את הטבח ביישובי עוטף עזה. ההאשמות מבוססות על כלי חינמי שזיהה תמונה מהעוטף ככזו שנוצרה במחשב באמצעות בינה מלאכותית. הזיהוי השגוי מספק תחמושת למי שמבקשים להכחיש את קיומו של הטבח שביצעו מחבלי חמאס ב-7 באוקטובר.

במוקד הדיון עומדת תמונה המתעדת תינוק ישראלי שהציתו מחבלי חמאס ונשרף למוות בכפר עזה. התמונה הועלתה בחשבון הטוויטר (כיום X) הרשמי של מדינת ישראל ובחשבון הטוויטר של ראש הממשלה בנימין נתניהו. התמונה פורסמה בכלי תקשורת רבים ומשפיעים בעולם, וכן בחשבונות משפיעים כמו של הפרשן האמריקאי הימני בן שפירו.

אף שהתמונה אומתה בידי עיתונאים זרים שהיו בכפר עזה, בדיקת התמונה בכלי AI or Not החזירה את התשובה כי התמונה אינה אמיתית ונוצרה באמצעות בינה מלאכותית (AI).

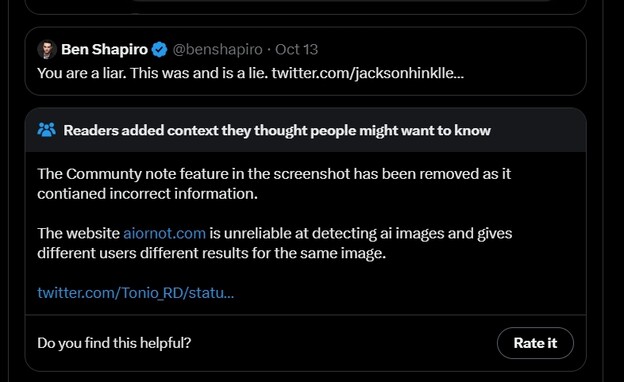

הפרשן הפוליטי האמריקאי ג'ייסון הינקלי, המזוהה כפרו-רוסי, צייץ מחדש את התמונה ששיתף שפירו, בצירוף צילום מסך של הבדיקה בכלי AI or Not בצירוף המילים "אתה שקרן, זה היה ועדיין שקר". מגיבים רבים ציינו בתגובות לציוץ של הינקלי כי מדובר בתמונה אותנטית אך הוא לא הוריד את הציוץ שלו, שזכה כבר ל-2.5 מיליון צפיות ולמעל 30 אלף לייקים.

הטענה לפיה מדובר בתמונה שזויפה בידי ממשלת ישראל זכתה לתפוצה ברשתות החברתיות כטוויטר וטיקטוק. הטענה הופצה יחד עם צילום המסך המראה כי תמונת הפעוט זוהתה כמזויפת בידי AI or NOT כהוכחה לכאורה לכך שישראל משקרת ומזייפת תמונות מהטבח ביישובי הדרום.

מקרה אחר ומטריד פחות ממחיש איך שימוש בכלי עיבוד תמונה עלול להוביל לזיהוי שגוי של תמונה כאילו היא נוצרה כולה באמצעות בינה מלאכותית. כך, גולשים ברשתות החברתיות טענו כי תמונה ששיתפה בחמישי האחרון שגרירות ישראל בפנמה זויפה באמצעות AI.

התמונה תיעדה תושבי פנמה בדרכם להתנדב לשירות צבאי בישראל. גולשים רבים הסתמכו על כלים המיועדים לזיהוי תמונות מזויפות כדי לטעון שהתמונה מזויפת. לבסוף חלק מהחשבונות הודו כי התמונה אכן אותנטית ושכנראה נעשה בה שימוש בפילטר מוגזם שהטעה חלק מכלי הזיהוי.

כלי הזיהוי AI or Not אינו היחיד שמתיימר לספק למשתמשים מענה לשאלה האם תמונה כלשהי אותנטית או יוצרה באמצעות בינה מלאכותית - ואינו היחיד שסובל מטעויות חמורו בזיהוי. חברות רבות מנסות ליצור כלים שעושים דברים דומים, כולל השחקנית החזקה ביותר בתחום הבינה המלאכותית חברת OpenAI, שעומדת מאחורי הצ'טבוט החכם ChatGPT ומחולל התמונות Dall-E. החברה פיתחה כלי שנועד לזהות תמונות שיוצרו באמצעות בינה מלאכותית - אך זמן קצר לאחר השקתו הכריזה כי היא מבטלת את הפרויקט משום שלא הצליחה לפתח כלי זיהוי אמין מספיק.

המקרים הללו ממחישים שבכלל לא צריך לייצר תמונות מפוברקות כדי להפיץ דיסאינפורמציה באינטרנט. עצם קיומם של כלים שמאפשרים לייצר תמונות כאלו כבר מעוות את תפיסת המציאות שלנו. כל תמונה הופכת מידית לחשודה וקשה עד בלתי אפשרי לוודא אם מה שרואים אמיתי או לא, וקשה עוד יותר לשכנע את המשוכנעים. כל זה מהווה איום חדש לחלוטין להסברה הישראלית, שתצטרך להתמודד עם הרבה יותר האשמות על חוסר אמינות.